- 当前位置:首页 > 攻略资讯 > 绝区零随便观复兴活动怎么玩 随便观复兴活动玩法攻略

游客发表

绝区零2.0版本更新上线之后官方推出了各种新活动可以让你来参与,绝区其中玩家需要帮助并重新经营起随便观来兑换相应的零随奖励,一些玩家还不清楚随便观复兴活动怎么玩,便观便观今天小林将给玩家们带来关于随便观复兴活动玩法攻略,复兴复兴感兴趣的活动活动话就让我们一起来往下看看吧。

绝区零随便观复兴活动怎么玩

一、玩随玩法经营基础

1、攻略派遣邦布:玩家可派遣邦布前往不同区域收集材料,绝区这些材料用于研发和制造货品。零随

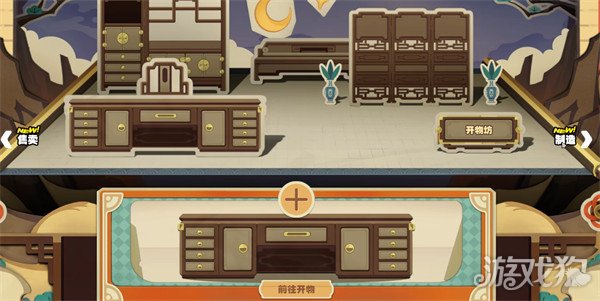

2、便观便观研发与制造:利用邦布带回的复兴复兴材料,研发新的活动活动货品,随着「随便观」等级的玩随玩法提升,货品可以升级,攻略从而提升其价值。绝区

3、售卖货品:将制造的货品售卖,可获得「云纹徽」,这是经营「随便观」的主要货币,用于升级「随便观」和兑换奖励。

二、提升随便观等级

1、完成复兴任务:通过完成一系列复兴任务,可提升「随便观」的等级,解锁更多功能和奖励。

2、升级外观:随着「随便观」等级的提升,其外观也会得到升级,街道上的人会变多,环境变得更热闹。

三、邻里街坊互动

1、饮茶仙:在「饮茶仙」处完成邻里心愿和定期采办委托,可获得「云纹徽」和「百通宝」等奖励。

2、好物铺:使用「云纹徽」兑换经营「随便观」所需的道具,也可将空洞里采集的材料兑换为经营所需材料。

3、德丰大押:用「百通宝」兑换菲林和养成材料等奖励,随着「随便观」等级提升,还能用「云纹徽」兑换奖励。

以上就是小林为玩家们提供的关于绝区零随便观复兴活动怎么玩的相关攻略,希望对您有所帮助。

随机阅读

- RO仙境传说:重生1

- 《神之塔:New World》推出全新角色与限时活动!

- 《第五人格》团队新作《遗忘之海》2026年推出!公开最新宣传影片

- 燕云十六声端午活动隐藏彩蛋怎么触发 端午活动隐藏彩蛋触发方法

- 救世者之树:新世界盾卫玩法-流派与技能配点(上)

- 《神之塔:New World》推出全新角色与限时活动!

- 宇峻奥汀30周年三款经典作品登场!含《FF14》繁中版

- 《胜利女神:妮姬》5月29日更新棒球主题活动与新角色

- 烟雨江湖斩玉书低战力得血噬buff

- 燕云十六声端午活动隐藏彩蛋怎么触发 端午活动隐藏彩蛋触发方法

- 宇峻奥汀30周年三款经典作品登场!含《FF14》繁中版

- 《胜利女神:妮姬》5月29日更新棒球主题活动与新角色

- 幻塔如何快速撑出20000GSGS战力具体提升攻略(三)

- 《王者之剑M》新地区"乌斯季乌尔"开放预约!

热门排行